最近站長在跟別人聊天時,說到關於人工智慧與機器學習的話題,有人意外提出了這個問題:「ChatGPT 很會一本正經的講幹話,有辦法快速簡單的找出 AI 說的錯誤訊息嗎?」這個問題讓我陷入思考,當下給不出任何答案。回家找了一些資料,基本確定一件事:文字型 AI 內容糾錯,必須依賴用戶的使用習慣;影音、圖片型 AI 內容,則可以透過軟體協助判斷。

文字型 AI 內容,有一些工具可以簡單用來糾錯

先說結論,我並沒有找到適合大眾使用、可完全放心依賴的 AI Fact Checker 工具。理由在於,現階段的 AI Fact Checker 工具,本身多半也是利用 AI 大模型在做回應。這是一個無限循環,你又如何能確定,AI 給你的糾錯資訊本身是正確的呢?

當然,我還是可以提供一些目前查到的工具:

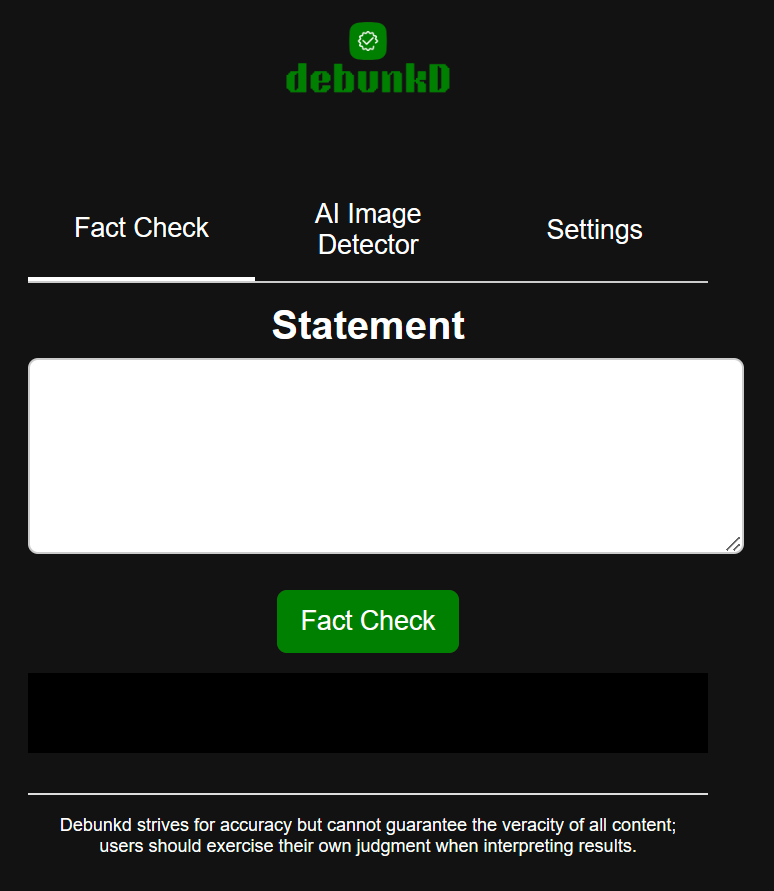

Debunkd:一款幫你判斷文字敘述是否正確的 Chrome Extension 軟體。它的優勢在於界面簡潔直覺、支援文字糾錯以及 AI 圖片協助判斷功能。當你輸入內容時,Debunkd 會幫你判斷是否正確,並且附上參考資訊來源出處;如果你輸入的是中文,它也會自動幫你翻譯成英文,再來幫你驗證正確性(但是他的回答一律是使用英文)。

聽起來是不是很迷人?但是這系統本身應該也是用 AI 在運行的(軟體頁沒有明確說明),在輸入框的下方,Debunkd 依舊有免責聲明:無法保證內容的正確性。

等等,這不就跟 ChatGPT 一樣了嗎?

另外,雖然它會提供參考資訊的來源,但這些來源點進去後有可能出現 404 無法顯示網頁,不確定哪裡出了問題。不過經過我個人的測試,一些明顯的錯誤,它還是能夠辨識出來的,但問題依舊:我無法放心的完全相信它,在重要時刻我可能還是要「想辦法驗證這個驗證工具所驗證出來的資訊的正確性」,無限套娃。

Bing Chat、Google Bard:我想,應該不需要解釋了吧?這是微軟與 Google 所推出的兩款 AI 聊天機器人。當你無法確定 ChatGPT 生成的内容是否正確時,或許可以考慮使用這兩款 AI 聊天機器人進行「交叉驗證」,看看這兩款機器人有沒有不一樣的看法。

當你使用 Bing 的時候,則可以利用 ChatGPT、Bard 來驗證,以此類推。不過問題跟前面的 Debunkd 相同,這些工具全都無法保證它的正確性,你還是不能完全放心的運用他們來糾錯。

面對 AI 生成的假消息,還是需要靠用戶改變習慣來對抗錯誤

這說來容易,但做起來難,簡單講就是媒體識讀的一部分:用戶要養成尋找「消息來源」的好習慣。

今天無論你看到的內容,是來自 AI 如 ChatGPT、是來自媒體、來自 YouTube 或抖音,來自 PTT 爆卦,還是來自 Dcard 分享,你都必須習慣主動驗證消息的正確性。

如何驗證?不是再去找另一家媒體的說法(這或許有用,但大部分沒用,因為現在天下媒體一大抄,看十篇有九篇是自體繁殖,都來自同一個出處),而是回頭找最原始的內容來看:

- 是來自英文、俄文還是韓文、簡體中文的報導嗎?你看看原始消息來源,是地方小報?是大媒體?有誰背書嗎?

- 原始來源是論文嗎?你找出來看看,這論文有經過同儕審查嗎?別人有對論文進行評論嗎?

- 還是根本沒有原始來源,來源不可考呢?或是來源根本是一個社交媒體的假帳號?

到頭來,用戶自己的判斷,依舊是最重要的一環。很多時候,你可以從「其他人對於該消息的評論」來間接找到有用的訊息。(首先你必須無視那些聳動的、訴諸民粹的無效評論,從無數內容中辨識出有幫助的資訊。當然,這依舊需要依賴個人的判斷能力。)

AI 內卷時代來臨:錯上加錯,垃圾訊息大爆發

如果你想偷懶、節省時間,透過上面我提供的 AI 工具進行交叉判斷,可能是最簡單的 AI 糾錯方式,但相對應的,你必須承擔「可能發生的錯誤」風險。事實上,隨著網路 AI 內容的增加,想要透過搜尋引擎糾錯、找到問題的答案,也變得越來越困難,因為 AI 時代讓一切都內卷了起來。

由 AI 所生成的錯誤訊息,被發送到網路上,再被搜尋引擎收錄,你找到的資訊很可能依舊是錯誤資訊。可怕的還沒結束,AI 的訓練每天都在發生,這些被發送到網路上的錯誤資訊,很可能再被收錄成大數據的一部分,再被拿去訓練 AI,更加强了 AI 生成內容的錯誤率 …。

目前還不確定這些 AI 大廠會如何避免這些問題,但可以確定的是,個人「尋找源頭資訊、判斷可信度」能力的重要性,在 AI 時代不但沒有下降,反而還更高了呢。

公開留言